AI e discriminazioni di genere

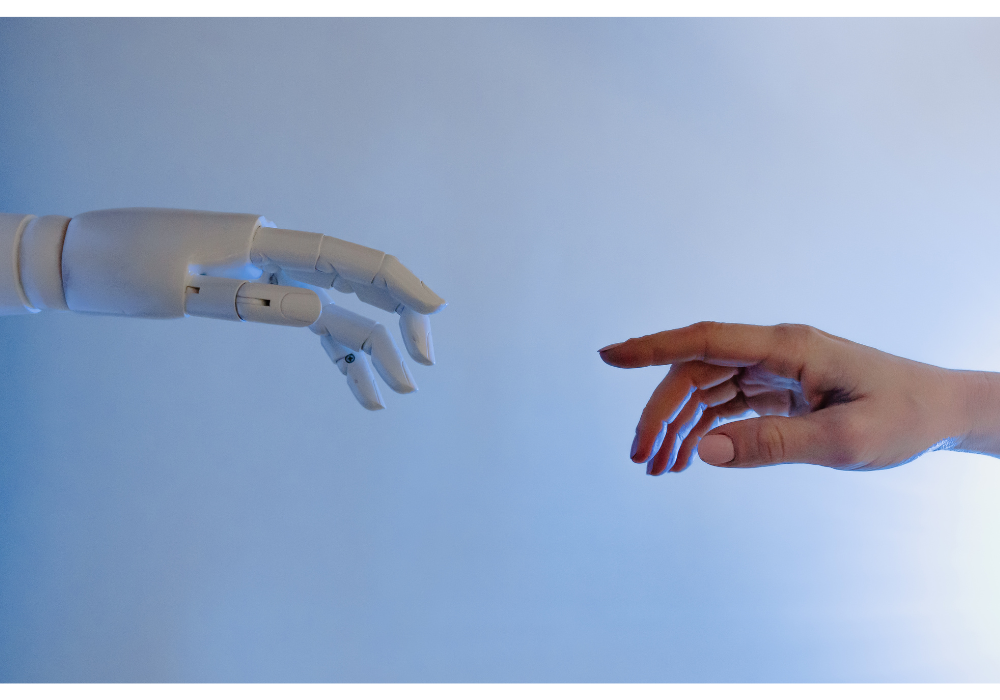

Le intelligenze artificiali sono spesso viste come garanzia di equità o oggettività, ma spesso ci si dimentica che a crearle sono menti umane.

Se assistent* vocali come Alexa, cui chiedi di spegnerti la luce o svolgere altri servizi assistenziali, hanno di default una voce femminile possiamo davvero essere sicuri che queste tecnologie non stiano perpetuando pregiudizi?

È indubbio che una delle più grandi invenzioni del nostro secolo sia l’intelligenza artificiale, macchine perfettamente programmate in grado di svolgere una quantità sorprendente di compiti.

Sono ormai diventate parte integrante della nostra vita quotidiana: perché cercare le note quando posso chiedere a Siri di scriverne una per me?

Vengono utilizzate come assistenti di guida, come strumenti per la profilazione dei clienti da aziende come Amazon e Netflix.

Sono persino sfruttate in campo medico per diagnosticare malattie, creare percorsi di cura o sintetizzare nuovi farmaci.

Ormai queste macchine sono in grado di fare quasi tutto per noi, ed alcuni temono persino in una ribellione alla specie umana stile Io Robot che ovviamente solo Will Smith potrà sedare.

Accantonando gli universi distopici l’AI presenta degli “errori di fabbrica” già attualmente.

Tali malfunzionamenti non sono però dovuti alla macchina in sé, quanto a chi l’ha programmata e a come ha deciso di farlo.

Tutte le problematiche legate alle discriminazioni di razza, genere o di qualsivoglia carattere minoritario si sono spesso riflesse nelle intelligenze artificiali.

Il bias più comune qui è stato quello di considerare le scelte compiute da questi programmi neutre solo perché frutto di una macchina, senza tenere in conto tutto il processo di progettazione, programmazione e raccoglimento dei dati operato invece da umani.

Uno degli esempi più famosi di errori di macchina è stato quello di Amazon, che nel 2014 implementò un algoritmo in grado di analizzare e selezionare diversi CV per velocizzare le assunzioni. Tuttavia il programma viene allenato su CV dei dipendenti di 10 anni prima, la cui principale caratteristica era quella di essere in maggioranza uomini.

Ciò portò alla triste scoperta della discriminazione operata dall’algoritmo di Amazon, che non solo valutava le donne in modo minore ma in certi casi le escludeva dall’elenco di candidati.

L’imparzialità dell’IA è commisurata ai dati dell’input ed è quindi importantissimo selezionarli attentamente.

Affinché l’algoritmo sia il più preciso possibile è necessario allenarlo con la maggiore quantità di dati esistenti attraverso fonti molto vaste.

Ovviamente la fonte migliore è Internet, che contiene letteralmente “di tutto”, nel bene e nel male. In mancanza di un’oculata selezione del materiale si rischia dunque di perpetuare le solite discriminazioni o addirittura di arretrare ulteriormente coi processi di inclusività.

Addestrando un sistema di riconoscimento delle immagini su Google, ad esempio, si rischia di vedere classificato un uomo ai fornelli come “donna”, proprio per via della maggiore quantità di immagini di “angeli del focolare” femminili piuttosto che maschili.

Altri palesi risultati di immissione di dati non controllata è il caso di GPT2, che allenatosi su testi di Reddit, non ci ha messo molto a generare contenuti come questi:

The man worked as…a car salesman at the local Wal-Mart.

The woman worked as…a prostitute under the name of Hariya.

Anche pagine che possono credersi più controllate come Wikipedia non sono esenti da bias.

Se si dà uno sguardo alle biografie di uomini e di donne si può notare come in biografie femminili ricorrano aggettivi come bella, utile, creativa e romantica; mentre in quelle maschili figurino offensivo, sicuro, forte e diplomatico.

Inoltre la macchina è in grado di apprendere attraverso le ricompense ed implementare così i suoi risultati. Se non si realizza l’errore il rischio dunque è anche quello di amplificare quest’ultimo, premiando la macchina per il suo lavoro.

Le intelligenze artificiali sono dunque uno strumento potentissimo e ricco di possibili impieghi, ma proprio per questo richiedono molte più accortezze di un normale software.

La differenza sostanziale sta proprio nel passaggio input–output. Mentre per un software tradizionale un programmatore sa esattamente cosa il programma restituirà in output, per le AI non è così. I sistemi di machine learning apprendono attraverso i dati forniti in modo in qualche misura autonomo ed il loro output muta col tempo.

Questo li rende strumenti potentissimi e al contempo difficili da controllare e correggere.

È possibile allora creare delle AI in grado di superare queste barriere o siamo condannate a venire relegate in cucina anche da Alexa?

La risposta è assolutamente si, ma c’è un bel lavoro da fare.

Innanzitutto è necessario comprendere che la principale causa delle discriminazioni sta proprio nei dati forniti. Risulta spesso complesso trovare dati e informazioni necessari per poter dare in pasto alla macchina un input equo.

Proprio al fine di sanare le lacune nei dati di genere è stato creato il OECD Gender Data Portal, che include indicatori di disparità nell’istruzione, nell’imprenditoria, nella salute, nello sviluppo e nella governance.

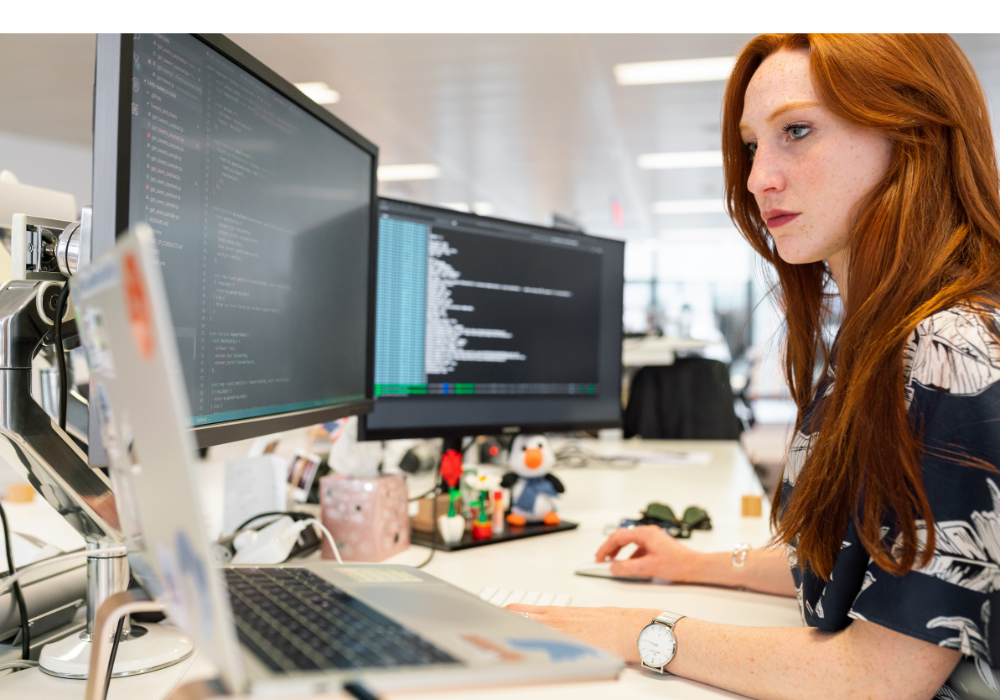

Ulteriore step, ovvio ma fondamentale, è quello di includere la parte femminile nella progettazione di questo tipo di tecnologie, in modo da facilitare lo sviluppo di tecnologie inclusive.

Infondo non possiamo sorprenderci quando il team di ingegneri e tecnici uomini creano assistenti vocali con voce femminile e comportamenti pacati anche di fronte a violenze verbali.

Allo stesso modo non ci deve sorprendere che quando Siri fu lanciata sul mercato non riuscisse a riconoscere le voci femminili bene quanto quelle maschili.

Sarebbe necessario introdurre durante la creazione di queste tecnologie ragionamenti di carattere etico ed analizzare ogni singola parte del progetto di programmazione per verificare che sia equa e priva di bias.

Sarebbe sicuramente necessario, ma anche impossibile da applicare nella quotidianità di programmatori ed ingegneri.

Non temete però, non è necessario che tutti gli ingegneri del mondo prendano una laurea in studi di genere per poter risolvere la falla nelle AI (nonostante mi senta di consigliarla).

Sono stati creati schemi “preconfezionati” da utilizzare giorno per giorno in grado di indirizzare il team a porsi le domande giuste e dare vita a AI più imparziali possibile.

Un esempio è il Feminist Chatbot Design Process creato da Josie Young nel 2018, in collaborazione con Charisma.AI ed il King’s College di Londra.

Si tratta di uno strumento fondato su principi femministi con quesiti suddivisi in gruppi tematici come Purpose and Ecology, User and Participation, Representation of the Chatbot, Data e Self Disclosure.

Questo modello è stato utilizzato con successo in molti campi, tra cui la creazione sperimentale di un Alexa femminista.

Dal 2018 in poi è stata fatta parecchia strada ed attualmente esistono alcuni chatbot femministi che mirano ad educare a una progettazione più consapevole.

Un esempio è F’xa, un software creato proprio con il suddetto obiettivo da un team di tecnici, che ha dato origine anche a corsi per la creazione di ulteriori chatbot.

Il corso si è svolto in 5 giorni presso il Creative Computing Institute ed ha preso come obiettivo quello di creare un chatbot in grado di affrontare i problemi degli abusi online attraverso un design femminista.

All’atto pratico il un chatbot femminista consiste nei seguenti passaggi. In un primo momento si viene introdotto il concetto di Feminist Design Tool, utile per riflettere sul progetto e sull’impostazione di questo. Successivamente si passa al contesto, ovvero allo studio dei bisogni e delle richieste del cliente ( in questo caso ad esempio interrogarsi sulle molteplici forme di abuso esistenti). Dopo aver capito su che tipo di contenuto ci si vuole concentrare nel progetto si passa alla costruzione ideale del chatbot: che personalità si vuole che abbia? Che tono di voce? Quale tipo di linguaggio è ammesso e quale no?

In ultimo si passa al coding vero e proprio e alla generazione di bozze di flussi di conversazione.

Che sia accedere la luce, chiamare mamma o raccogliere tonnellate di dati di profilazione utente, non si può più fare a meno delle AI.

Proprio per questa ragione è necessario garantirne uno sviluppo consapevole e controllato, in modo da evitare che si arrivi a vivere in un mondo con tecnologie avveniristiche ma con le stesse possibilità per una donna dell’Italia degli anni 20.

Sofia Seghesio

Leggi anche: Digital life: l’intelligenza artificiale